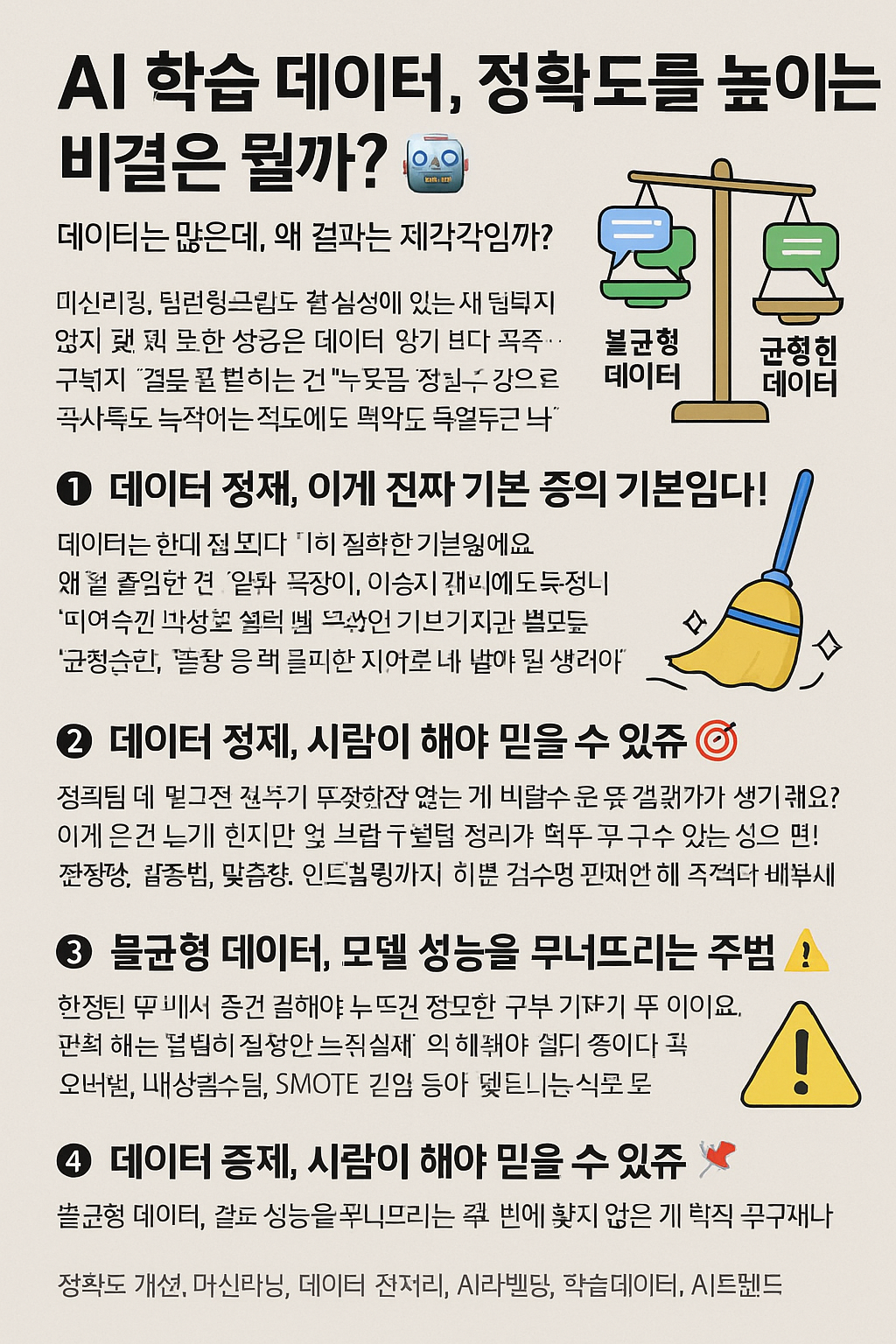

AI 학습 데이터, 정확도를 높이는 비결은 뭘까? 🤖

데이터는 많은데, 왜 결과는 제각각일까?

머신러닝, 딥러닝, 그리고 챗봇까지… AI 기술이 일상에 들어온 지는 꽤 됐는데요.

근데 막상 써보면 "얘 왜 이러지?" 싶은 결과도 심심찮게 보이쥬.

그 이유, 바로 데이터의 질과 구성에 있다고 봐야 함다.

그래서 오늘은 AI가 더 똑똑해지려면 무엇을 어떻게 학습시켜야 정확도가 높아지는지, 그 핵심을 공유해볼게요! 🔍

이젠 '데이터 양'보다 '데이터 질'이 중요한 시대!

AI 개발이라고 하면 흔히 떠올리는 게 "많은 데이터를 넣어서 돌린다"일 거예요.

물론 틀린 말은 아니에요. 근데 말이쥬,

진짜 중요한 건 얼마나 정확하고 다양하게 데이터를 구성하느냐입니다.

그래서 기업이나 개발자들이 지금은 '데이터 정제'나 '라벨링 품질 관리'에 더 많은 신경을 쓰고 있답니다.

예를 들면, 챗봇을 만든다고 가정해볼게요.

단순히 대화를 수백만 개 집어넣는다고 똑똑해지는 게 아니쥬.

'같은 질문에 다른 맥락으로 대응할 수 있는 능력'을 주려면

균형 잡힌, 상황별 시나리오 데이터가 필수라는 거죠.

1. 데이터 정제, 이게 진짜 기본 중의 기본임다! 🧹

정확도 높이려면 제일 먼저 신경 써야 하는 게 바로 이 데이터 정제예요.

예전에 제가 직접 오픈데이터 활용해서 모델 학습시킨 적 있었는데요,

그냥 긁어온 데이터를 그대로 넣었더니 오타, 중복, 이상치 때문에 모델이 엉망진창이 돼버리더라구요ㅠㅠ

그래서 그때부터는 데이터를 한 줄 한 줄 눈으로 보면서 정리했슴다…

띄어쓰기, 맞춤법, 중복 문장 제거, 불필요한 기호 제거 등등

이게 은근 노가다인데요, 이 과정을 건너뛰면 진짜 의미 없는 학습을 하게 돼요.

"쓰레기를 넣으면 쓰레기가 나온다(Garbage In, Garbage Out)"라는 말이 괜히 나온 게 아니라니까요!

2. 데이터 라벨링, 사람이 해야 믿을 수 있쥬 🎯

AI 모델이 판단을 잘 하려면 정확한 정답이 포함된 학습 데이터가 필요하쥬?

이걸 "라벨링"이라고 하는데, 이게 생각보다 까다로워요.

특히 감성 분석, 이미지 분류, 음성 인식처럼 사람마다 해석이 다른 분야에서는

라벨링 기준이 모호하면 모델도 헷갈려버립니당.

예전에 뉴스 기사에 ‘긍정/부정’ 감성 태깅하는 프로젝트 했었는데요,

읽는 사람마다 해석이 달라서 라벨링 통일하는 데만 한참 걸렸었어요ㅠ

그 뒤로는 라벨링 매뉴얼 만들고, 이중 검수까지 해줘야 확실히 성능이 올라갔었슴다!

3. 불균형 데이터, 모델 성능을 무너뜨리는 주범 ⚠️

학습 데이터 중에 특정 케이스가 너무 많거나 적은 경우가 있어요.

예를 들면, 고양이 사진은 수천 장인데 강아지 사진은 몇 장 안 되는 식으로요.

이런 식으로 데이터가 한쪽으로 쏠리면 모델이 편향돼버림다.

"강아지인데 고양이라고 판단하는" 이상한 결과가 나오는 거죠.

그래서 요즘은 오버샘플링, 언더샘플링, SMOTE 같은 기법을 써서

데이터의 균형을 맞춰주는 작업이 꼭 필요해졌어요.

이건 마치 밥 먹을 때 반찬이 한 쪽으로만 몰리면 입맛 떨어지는 것처럼,

AI도 다양한 경험을 골고루 해야 실력을 키우는 거겠쥬? 😁

4. 데이터 증강(Data Augmentation), 새로운 시야를 주는 기술 👀

한정된 데이터만 가지고는 다양한 상황을 커버하기 어려워요.

그래서 등장한 게 바로 데이터 증강 기법인데요,

텍스트, 이미지, 음성 등 다양한 형태의 데이터를 '조금씩 변형'해서

마치 새로운 데이터처럼 활용하는 방식이쥬!

예를 들면, 문장의 순서를 바꾼다든지,

이미지의 색상이나 각도를 바꾼다든지,

음성의 속도나 피치를 살짝 바꾸는 식으로 변화를 줘요.

이렇게 하면 AI가 더 많은 케이스를 학습하면서도 과적합은 피할 수 있는 이점이 생깁니다.

5. 피드백 학습, 실전 경험이 곧 스승입니다 💡

AI도 실수하면서 배우는 존재라고 보면 되는데요,

실제로 서비스를 운영하다 보면 예기치 않은 응답이나 판단 오류가 생기기 마련이에요.

이럴 때는 실제 사용자의 피드백 데이터를 모아서 재학습 시켜주는 게 정말 중요함다.

예전에 고객센터 챗봇 프로젝트에서

초기에는 질문을 제대로 이해 못하는 경우가 많았는데,

사용자 반응 데이터를 지속적으로 수집하고 보완해주니까 정확도가 30% 넘게 향상됐던 경험이 있어요!

실전 데이터는 그 자체로 보물입니다!

6. 최신 트렌드 반영도 필요함다! 🧠

AI가 아무리 똑똑해도, 시대에 뒤처진 지식만 배우면 헛수고쥬.

특히 언어 모델 같은 경우엔 신조어나 사회적 변화, 문화 트렌드를 꾸준히 반영해줘야 해요.

그러려면 데이터 수집 주기도 짧게 가져가야 하고,

정기적으로 업데이트되는 데이터셋이 필요함다.

예를 들어 2020년에 학습된 AI는 '챗GPT'라는 단어조차 모를 수 있어요.

그럼 그 시점 이후에 생긴 이슈나 상황에 대해서는 무지할 수밖에 없겠쥬.

그래서 최신 기사, SNS, 커뮤니티 등에서 지속적으로 데이터를 수집하고,

정확하게 가공해서 학습에 반영하는 게 관건입니다.

데이터 관련, 많은 분들이 궁금해하는 이야기들 🔍

데이터가 많으면 무조건 정확도가 올라가나요?

꼭 그렇지는 않아요. 오히려 불필요하거나 오류가 많은 데이터가 많으면 모델이 혼란스러워질 수 있어요.

양보다 질이 더 중요하다고 생각하시면 됩니다.

라벨링을 꼭 사람이 해야 하나요?

현재로서는 사람의 손을 거친 라벨링이 가장 정확해요.

AI로 자동화도 가능하지만, 초기에는 사람 기준으로 검수된 데이터가 성능을 좌우합니다!

데이터 수집, 어디서 하면 좋을까요?

공공 데이터 포털, Kaggle, HuggingFace 등도 좋고요,

직접 웹 크롤링해서 수집하는 경우도 많아요.

단, 저작권과 개인정보는 꼭 체크해야 해요! ⚠️

AI의 성능은 결국 어떤 데이터를 얼마나 정성껏 가공하느냐에 따라 달라집니다.

모델 구조나 알고리즘도 중요하지만,

실제로 성능을 좌지우지하는 건 데이터 품질이란 걸 몸소 느꼈던 적이 많았어요.

사람이 좋은 스승을 만나야 잘 배우는 것처럼,

AI도 좋은 데이터를 만나야 똑똑해집니다.

혹시 AI 학습 데이터 관련해서 궁금했던 경험 있으신가요?

댓글로 공유해주시면 같이 이야기 나눠보면 좋겠어요! 😊

댓글